La IA predictiva y la IA generativa son dos disciplinas muy diferentes que, al parecer, se necesitan mutuamente con urgencia. Dado que cumplen propósitos distintos, los proyectos que las emplean suelen estar aislados. Sin embargo, estas dos variantes de IA están destinadas a fusionarse, ya que cada una es adecuada para abordar las mayores limitaciones de la otra: la IA generativa es costosa y, a menudo, poco fiable, mientras que la IA predictiva es difícil de usar.

Abordar sus limitaciones de esta manera es clave para lograr la fiabilidad que la IA necesita y así mitigar la inminente detonación de la burbuja de la IA . En el artículo anterior, se expone cinco maneras de hibridar la IA generativa y la predictiva para que se complementen:

- 1. Abordar el problema de confiabilidad de genAI apuntando de manera predictiva a la intervención humana en el circuito

- 2. Abordar la complejidad de la IA predictiva con un chatbot que sirva como asistente y socio de pensamiento para dilucidar, aclarar y sugerir.

- 3. Utilizar genAI para “generar código” para proyectos de IA predictiva.

- 4. Utilizar genAI para derivar características predictivas.

- 5. Utilizar modelos de bases de datos de gran tamaño, que emplean métodos similares a los modelos de lenguaje de gran tamaño para aprender de datos estructurados y hacer que el desarrollo de IA predictiva sea más sencillo.

Para ampliar esos cinco, aquí hay dos formas más en que genAI y la IA predictiva funcionan mejor juntas.

GenAI explica las decisiones de la IA predictiva

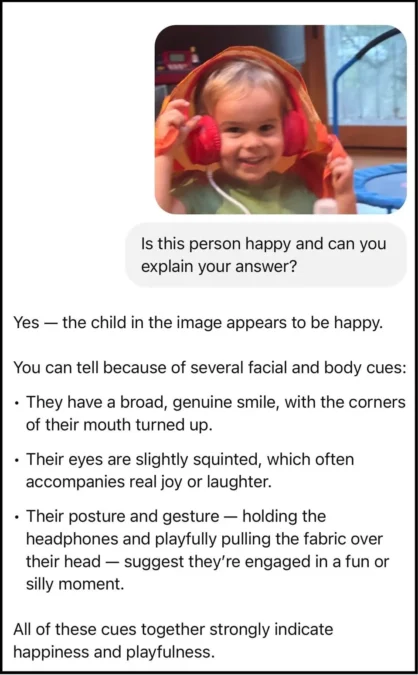

Es casi evidente que genAI puede explicarse por sí solo. Introduje una foto de mi hijo en chatGPT, junto con la pregunta: «¿Esta persona está contenta? ¿Puede explicar su respuesta?», y funcionó perfectamente (aunque un solo ejemplo no demuestra su fiabilidad en general).

Esta capacidad se extiende a la toma de decisiones mecánica y a gran escala que la IA predictiva implementa para dominios altamente sensibles, como las decisiones crediticias y el diagnóstico médico.

Si bien estos proyectos de IA predictiva tienden a emplear modelos más simples que los de genAI, estos modelos predictivos pueden ser demasiado complejos para que los humanos los comprendan en su forma básica. Mucho antes de la llegada de los transformadores, los grandes modelos de lenguaje y genAI, los métodos de aprendizaje automático que sustentan la IA predictiva ya eran conocidos por generar cajas negras. En proyectos que van más allá de métodos más simples, como árboles de decisión y regresión logística, y que en su lugar utilizan métodos más sofisticados, como modelos de conjunto y redes neuronales, los modelos resultantes eran, y siguen siendo, generalmente impenetrables, demasiado complejos de comprender.

El campo del aprendizaje automático explicable, también conocido como IA explicable o XAI, surgió para proporcionar a los humanos una visión de cómo un modelo de ML impulsa las decisiones. Para muchos proyectos, esta comprensión humana es crucial para evaluar los modelos en función de consideraciones éticas o para ganarse la confianza de las partes interesadas, quienes solo se sienten cómodas dando luz verde cuando se les proporciona una idea intuitiva de qué hace que un modelo funcione.

Sin embargo, el aprendizaje automático explicable a menudo no logra aclarar completamente las cosas. Si bien los enfoques XAI proporcionan información técnica que los expertos en aprendizaje automático comprenden, no necesariamente cubren por completo la brecha de comprensión al ofrecer explicaciones a las partes interesadas del negocio.

Presentamos genAI, que traduce explicaciones técnicas a un inglés sencillo (u otros lenguajes humanos). Por ejemplo, el sistema TalkToModel mantiene diálogos como este:

Humano: El solicitante 358 quiere saber por qué le denegaron el préstamo. ¿Podrías explicarmelo?

TalkToModel: Se le negó el préstamo debido a sus ingresos y puntaje crediticio.

Humano: ¿Qué podrían hacer para cambiar esto?

TalkToModel: Aumenta su puntaje de crédito en 30 y sus ingresos en $1,000.

XAI no solo tiene como objetivo explicar una decisión individual a la vez, sino también brindar información sobre el proceso de toma de decisiones de un modelo en general:

Humano: ¿Qué tipos de pacientes el modelo suele predecir incorrectamente (diabetes)?

TalkToModel: Para datos con edad mayor a 30 años, el modelo suele predecir incorrectamente. Si el IMC es > 26,95, la glucosa < 125 y el pedigrí < 0,943, el modelo es incorrecto en el 62,3 % de las 53 muestras.

Al abordar fácilmente la necesidad de explicaciones en lenguaje sencillo, genAI para XAI es un área vital, prometedora y de rápido crecimiento.

La IA predictiva se aproxima de forma económica a GenAI

Los modelos GenAI son de propósito general. En lugar de especializarse en una sola tarea, ofrecen una aplicabilidad muy amplia. Sin embargo, los modelos GenAI solo logran esta generalidad gracias a su gran tamaño y, por lo tanto, su alto coste computacional. Independientemente de su uso, GenAI conlleva una gran sobrecarga.

¿La solución? Entrenar un modelo de IA predictiva más ligero para emular genAI, para una tarea individual a la vez.

Por ejemplo, un fabricante en India necesita validar un millón de tiendas minoristas, en parte analizando fotos tomadas por el personal de ventas. Algunas fotos son fraudulentas, en parte debido a un incentivo que se les da para que envíen un buen número de fotos de la tienda para confirmar el alcance de sus esfuerzos de ventas en el campo. Además, otras fotos son inaceptables porque no cumplen con ciertos estándares visuales. Si las fotos no válidas no se detectan, el fabricante paga costos al desperdiciar esfuerzos de ventas, obtener métricas inexactas y otros problemas.

GenAI ofrece un enfoque sólido: simplemente muéstrale una foto de la tienda y házle preguntas relacionadas con su validación, como por ejemplo si la señalización y los productos son visibles, si es de día y la tienda mostrada está abierta y si se muestra el exterior completo de la tienda.

Pero aplicar este enfoque a un millón de imágenes resultaría prohibitivamente caro. Rohit Agarwal, director de IA de Bizom, proveedor de IA, ha demostrado que la IA predictiva soluciona este problema (como presentó en la serie de conferencias que fundé, Machine Learning Week 2025; haga clic aquí para ver sus diapositivas detalladas ).