A principios de junio, Amanda Claypool buscaba trabajo en un restaurante de comida rápida de Asheville, Carolina del Norte. Pero se encontró con un obstáculo inesperado y molesto: los chatbot de los reclutadores.

Algunos ejemplos: «Olivia», el chatbot de contratación de McDonald’s, dio el visto bueno a Claypool para una entrevista en persona, pero luego no pudo concertarla por problemas técnicos. Un bot de Wendy’s consiguió concertarle una entrevista en persona, pero era para un trabajo que ella no podía desempeñar. Luego, un chatbot de Hardees la envió a una entrevista con un gerente de la tienda que estaba de vacaciones, algo que no es una estrategia de reclutamiento perfecta.

«Me presenté en Hardees y se quedaron un poco sorprendidos. El equipo que operaba el restaurante no tenía ni idea de qué hacer conmigo o cómo ayudarme», dijo a Forbes Claypool, que finalmente aceptó un trabajo en otro lugar. «Parecía algo más complicado de lo que tenía que ser» (McDonald’s y Hardees no respondieron a la solicitud de comentarios. Un portavoz de Wendy’s dijo a Forbes que el bot crea «eficiencias de contratación», añadiendo que «la innovación es nuestro ADN»).

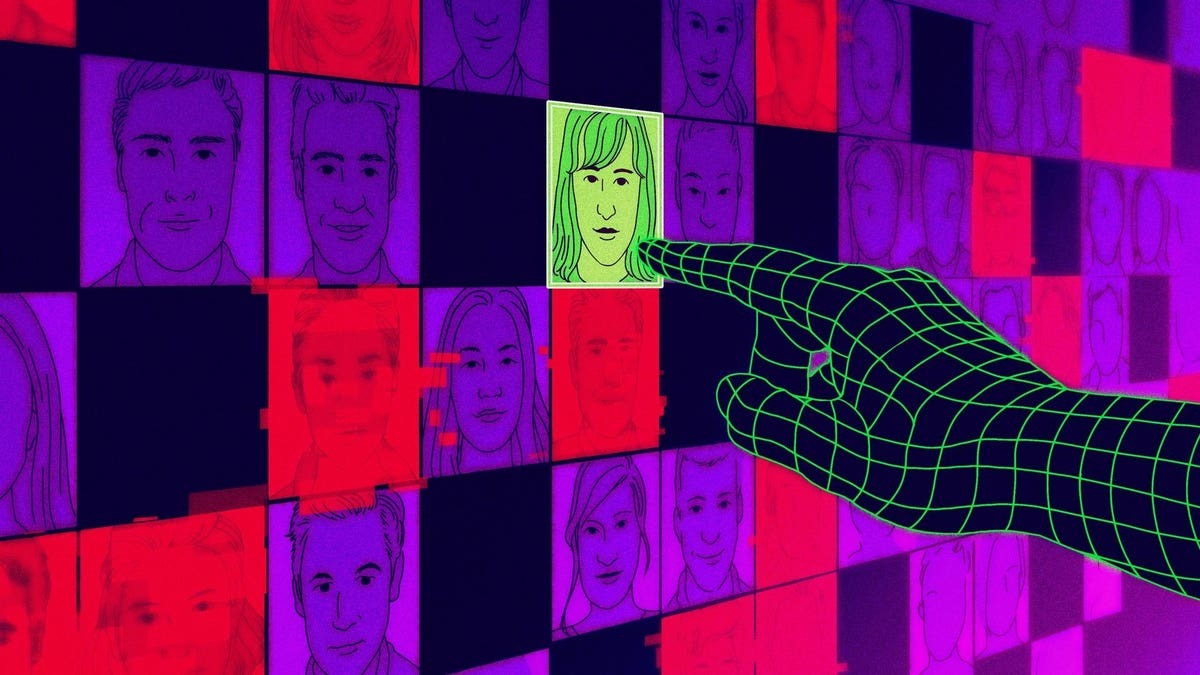

Los chatbots de RRHH como los que encontró Claypool se utilizan cada vez más en sectores como la sanidad, el comercio y la restauración para filtrar a los candidatos no cualificados y programar entrevistas con los que podrían ser adecuados para el puesto. McDonalds, Wendy’s, CVS Health y Lowes utilizan Olivia, un chatbot desarrollado por la empresa de IA Paradox, con sede en Arizona y valorada en 1.500 millones de dólares. Otras empresas, como L’Oreal, confían en Mya, un chatbot de IA desarrollado en San Francisco por una startup del mismo nombre (Paradox no respondió a una solicitud sobre la experiencia de Claypool).

La mayoría de los chatbots de contratación no son tan avanzados o elaborados como los chatbots conversacionales contemporáneos como ChatGPT. Se han utilizado principalmente para seleccionar puestos de trabajo con un gran volumen de solicitantes: cajeros, empleados de almacén y asistentes de atención al cliente. Son rudimentarios y hacen preguntas bastante sencillas: «¿Sabe utilizar una carretilla elevadora?» o «¿Puede trabajar los fines de semana?». Pero, como descubrió Claypool, estos robots pueden tener fallos y no siempre hay un humano al que recurrir cuando algo va mal. Y las respuestas tan claras que exigen muchos de los robots podrían significar el rechazo automático de algunos candidatos cualificados que no respondan a las preguntas como un gran modelo lingüístico quiere que lo hagan.

Según los expertos, esto podría suponer un problema para las personas con discapacidad, las que no dominan el inglés y los solicitantes de empleo de más edad. Aaron Konopasky, abogado asesor sénior de la Comisión para la Igualdad de Oportunidades en el Empleo (EEOC) de EE.UU., teme que chatbots como Olivia y Mya no ofrezcan a las personas con discapacidades o afecciones médicas opciones alternativas de disponibilidad o funciones laborales. «Si es un ser humano con el que estás hablando, hay una oportunidad natural para hablar sobre ajustes razonables», dijo a Forbes. «Si el chatbot es demasiado rígido, y la persona necesita poder solicitar algún tipo de exención, entonces el chatbot podría no darle la oportunidad de hacerlo».

La discriminación es otro motivo de preocupación. Los prejuicios subyacentes en los datos utilizados para entrenar la IA pueden hornear el sesgo y la discriminación en las herramientas en las que se despliega. «Si el chatbot se fija en cosas como el tiempo que tardas en responder, o si utilizas la gramática correcta y frases complejas, ahí es donde empiezas a preocuparte por los prejuicios», dice Pauline Kim, profesora de Derecho Laboral en la Universidad de Washington, cuya investigación se centra en el uso de la IA en herramientas de contratación. Pero este sesgo puede ser difícil de detectar cuando las empresas no son transparentes sobre los motivos por los que se rechaza a un posible candidato.

Recientemente, las autoridades gubernamentales han introducido legislación para supervisar y regular el uso de la automatización en las herramientas de contratación. A principios de julio, la ciudad de Nueva York promulgó una nueva ley que exige a los empleadores que utilizan herramientas automatizadas como escáneres de currículum y entrevistas de chatbot que auditen sus herramientas para detectar sesgos de género y raciales. En 2020, Illinois aprobó una ley que exige a los empleadores que aplican IA para analizar entrevistas en vídeo que notifiquen a los solicitantes y obtengan su consentimiento.

Aun así, para las empresas que buscan recortar los costes de contratación, los agentes de selección de IA parecen una opción obvia. Los departamentos de recursos humanos son a menudo uno de los primeros lugares en ver reducciones de personal, dijo Matthew Scherer, asesor principal de políticas para los derechos de los trabajadores y la tecnología en el Centro para la Democracia y la Tecnología. «Los recursos humanos siempre han sido un centro de costes para una empresa, nunca han generado ingresos», explicó. «Los chatbots son un primer paso muy lógico para intentar quitar parte de la carga a los reclutadores».

Esa es parte de la razón de ser de Sense HQ, que proporciona a empresas como Sears, Dell y Sony chatbots de IA basados en mensajería de texto que ayudan a sus reclutadores a abrirse paso entre miles de candidatos. La empresa afirma que ya la han utilizado unos 10 millones de solicitantes de empleo, y su cofundador, Alex Rosen, dijo a Forbes que esas cifras significan una reserva mucho mayor de candidatos viables.

«La razón por la que construimos un chatbot en primer lugar fue para ayudar a los reclutadores a hablar con una gama más amplia de candidatos de lo que podrían hacer por sí mismos», dijo, añadiendo la advertencia: «No creemos que la IA deba tomar la decisión de contratación por sí sola. Ahí es donde se vuelve peligroso. Creemos que aún no hemos llegado a ese punto».

RecruitBot está aplicando la IA a la contratación utilizando el aprendizaje automático para examinar una base de datos de 600 millones de solicitantes de empleo extraídos de LinkedIn y otros mercados de trabajo, con el objetivo de ayudar a las empresas a encontrar candidatos similares a sus empleados actuales. «Es como si Netflix te recomendara películas basándose en otras que te gustan», explica a Forbes Jeremy Schiff, consejero delegado y fundador de la empresa. Pero aquí también el sesgo es una preocupación obvia; contratar más de lo mismo tiene sus trampas. En 2018, Amazon retiró su sistema de seguimiento de currículos basado en aprendizaje automático que discriminaba a las mujeres porque sus datos de entrenamiento estaban compuestos en su mayoría por currículos de hombres.

Urmila Janardan, analista de políticas en Upturn, una organización sin fines de lucro que investiga cómo las tecnologías impactan en las oportunidades para las personas, señaló que algunas empresas también han recurrido a pruebas de personalidad para eliminar candidatos, y las preguntas para seleccionar candidatos pueden no estar relacionadas con el trabajo en absoluto. «Incluso es posible que te rechacen por preguntas sobre gratitud y personalidad», afirma.

En el caso de Rick Gned, pintor y escritor a tiempo parcial, un test de personalidad formaba parte de la entrevista que le hizo un chatbot para un trabajo por horas en un supermercado australiano, Woolworths. El chatbot, creado por la empresa de selección de personal Sapia AI (antes conocida como PredictiveHire), le pidió que respondiera a cinco preguntas de entre 50 y 150 palabras y, a continuación, analizó sus respuestas en busca de rasgos y aptitudes que coincidieran con las preferencias de los seleccionadores. Concluyeron que Gned «lidia bien con el cambio» y está «más centrado en el panorama general, lo que le hace mirar por encima de los detalles», y le hicieron pasar a la siguiente ronda de entrevistas. Aunque Sapia AI no exige a los candidatos que respondan a las preguntas con un límite de tiempo, el sistema mide la estructura de las frases, la legibilidad y la complejidad de las palabras empleadas en las respuestas de texto, explica Barb Hyman, CEO y cofundadora de Sapia AI, en un correo electrónico.

A Gned todo esto le pareció deshumanizante y preocupante, según declaró a Forbes. «Pertenezco a un grupo demográfico en el que no me afecta, pero me preocupan las personas que pertenecen a minorías, que conforman predominantemente el mercado laboral de menores ingresos».

Para un solicitante de empleo, que pidió el anonimato para hablar con libertad, chatear con un bot tuvo al menos un aspecto positivo. Cuando rellena cientos de solicitudes de empleo, a menudo nunca recibe respuesta, pero el bot al menos le aseguraba que su solicitud había sido recibida. «Fue una inyección de moral en muchos sentidos», afirma. «Pero si tuviera que hacer esto (enviar mensajes de texto con un chatbot) con cada trabajo al que me presentara, sería un coñazo».