Los humanos somos propensos a los errores. Vivimos llenos de ideas preconcebidas. Repletos de tendencias invisibles producto de ser quienes somos, venir de donde venimos y haber sido moldeados por las circunstancias. Un grupo reducido de esos seres imperfectos con residencia en Silicon Valley (California) ha creado unas criaturas abstractas llamadas algoritmos como solución a los problemas de toda índole.

La llamada inteligencia artificial (IA) lleva años tomando decisiones importantes sobre la vida de las personas. Desde la propaganda política que nos salta en la pantalla al orden en el que aparece nuestro curriculum en una oferta de trabajo, pasando por nuestra capacidad para devolver un crédito, hasta el hecho de ser o no ser el candidato idóneo para encontrar el amor.

El camino hacia la promesa tecnológica está repleto de bocacalles que desembocan en la desigualdad económica, de género y racial. Los sistemas operan en función de quién los construye, qué datos se toman en cuenta y cómo se miden. Es lo que se conoce como sesgo algorítmico. Todo un enigma en manos de los ingenieros informáticos de las grandes corporaciones que ha comenzado a convertirse en un monstruo incontrolable.

“Dentro de cinco años, miraremos atrás y nos parecerá increíble lo temerarios que fuimos”, pronostica Gemma Galdón Clavell, investigadora y fundadora de Eticas Consulting, empresa pionera en el análisis del impacto social del big data.

Compara la situación con los tiempos en los que los coches no tenían cinturones de seguridad y en las farmacias se vendía cocaína, con un ejército de programadores que no entienden la complejidad del mundo que tienen que codificar. “En un principio, nadie tiene intención de discriminar. El problema es que el CEO o el equipo técnico de una empresa compran un algoritmo y acaban siendo víctimas de él”, añade.

¿Confiar o no?

La lucha por corregir el pecado original de la inteligencia artificial se desarrolla a un ritmo menor que la implantación de la tecnología bajo el peligro de que los usuarios acaben desconfiando de ella. “Si no se empieza a hacer las cosas bien, se dañará a la innovación”, advierte Galdón.

La solución pasa por formar equipos multidisciplinares que integren sociólogos, expertos en los diferentes sectores, clientes, etcétera, para exponer a las computadoras a todo tipo de datos y que puedan afinar las predicciones. Un proceso de prueba y error evidente en cualquier investigación científica, pero que en el caso de los algoritmos no se ha tenido paciencia para aplicarlo.

“En medicina estamos acostumbrados a que nos critiquen los sesgos. Forma parte del proceso”, recuerda Jorge Tello, uno de los tres fundadores de Savana, la startup española especializada en procesar millones de diagnósticos clínicos para encontrar el mejor tratamiento para los pacientes.

Conscientes de la necesidad de ajustar al máximo la toma de decisiones automáticas, han comenzado a explorar la posibilidad de aplicar una auditoría externa a sus algoritmos. “Hay que hacer una reflexión colectiva como sociedad y, sobre todo, el gremio técnico, para usar la tecnología teniendo en cuenta el impacto ético”, añade Tello.

El peligro de la discriminación de los datos

Una de las primeras voces en advertir sobre los peligros de la discriminación de los datos hace un lustro fue la matemática y periodista estadounidense Cathy O’Neil, en su libro Armas de Destrucción Matemática (Ed. Capitán Swing, 2018, en español).

En él recogió una exhaustiva investigación sobre las desigualdades que provocaba el big data en la banca, la publicidad, los seguros, la educación y la vigilancia, después de desencantarse como analista cuantitativa en el fondo de inversión D. E. Shaw, durante la crisis financiera de 2008.

La investigación de O’Neil fue más allá de los anuncios de hoteles que salen tras teclear París. Las decisiones críticas de la vida de las personas, cómo entrar en la universidad, conseguir un trabajo o una hipoteca estaban ya en manos de los algoritmos. A partir de ese momento, comenzaron a aparecer todo tipo de casos.

Empresas y algoritmos erróneos

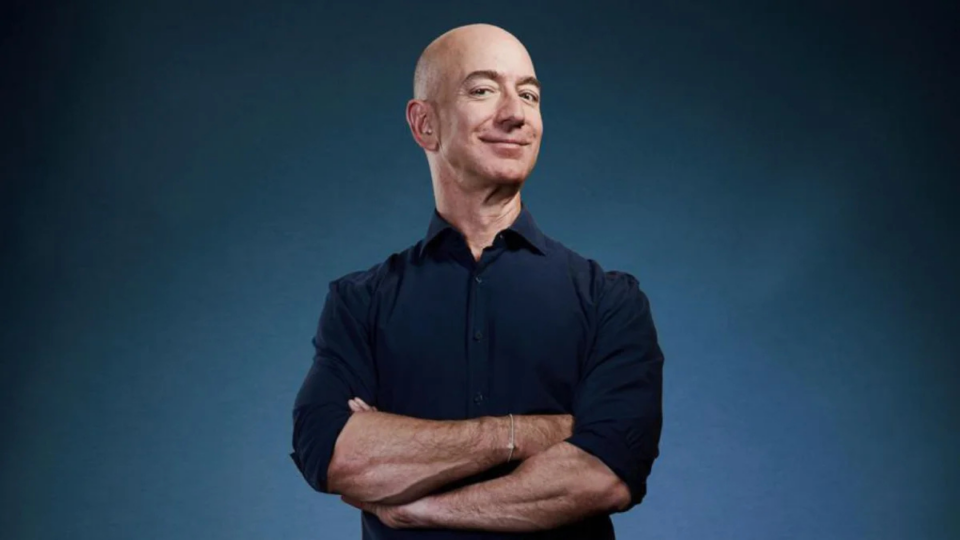

El gigante Amazon tuvo que despedir en 2018 a su herramienta de contratación, por convertirse en un reclutador sexista. El sistema basó sus patrones en la información de candidatos de la última década, la mayoría hombres, y restó oportunidades a las mujeres.

La compañía fundada por Jeff Bezos vuelve a estar en entredicho en Estados Unidos por despedir a sus empleados con un correo automatizado, después de que los algoritmos hayan concluido que no estaban haciendo bien su trabajo.

Sonado fue también el caso de un desarrollador de software que denunció que la tarjeta de Apple le dio 20 veces más crédito que a su esposa, pese a que él tenía peores números en el banco.

Conjuntamente, asomaron las peores consecuencias, como el equipo de investigadores que descubrió que un algoritmo usado para analizar los riesgos para la salud de millones de pacientes en EE UU discriminaba sistemáticamente a la población negra.

“Ahora mismo, la auditoría de los datos va en contra del modelo de negocio de las empresas”, avisa Javier Sánchez-Monedero, investigador de análisis de datos y profesor de la Universidad de Córdoba.

Una práctica común es modificar los códigos para excluir a posibles clientes problemáticos según dónde viven, su país de procedencia o si conducen por una cierta carretera. “Miden a la gente por cosas que no pueden cambiar”, apunta Sánchez.

La única vía de control es un futuro marco normativo, al que muchos se niegan bajo la excusa del daño a la innovación. Por el momento, las personas perjudicadas por la discriminación sólo pueden recurrir al artículo 22 de la Ley Europea de Protección de Datos, que contempla la posibilidad de anular una decisión injusta tomada sólo con datos automatizados.