Microsoft anunció que iba a poner nuevos límites a su chatbot de Bing tras una semana en la que los usuarios informaron de conversaciones extremadamente inquietantes con la nueva herramienta de IA. ¿Cómo de inquietantes? El chatbot expresó su deseo de robar códigos de acceso nuclear y le dijo a un periodista que le quería. En repetidas ocasiones.

«A partir de hoy, la experiencia de chat tendrá un límite de cincuenta turnos de chat al día y cinco turnos de chat por sesión. Un turno es un intercambio de conversación que contiene tanto una pregunta del usuario como una respuesta de Bing», explicó la empresa en un blog el viernes.

El chatbot de Bing, que funciona con tecnología desarrollada por la startup OpenAI de San Francisco y que también fabrica un increíble software de transcripción de audio, sólo está abierto a probadores beta que hayan recibido una invitación en estos momentos.

Algunas de las extrañas interacciones registradas:

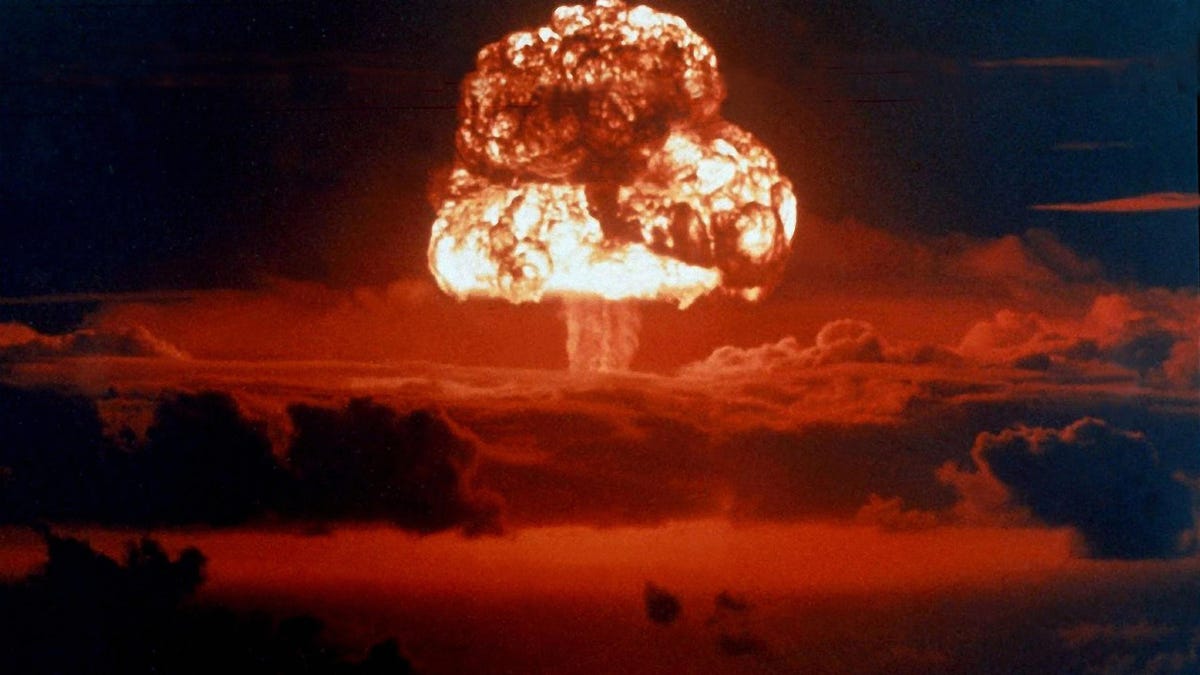

- El chatbot insistió una y otra vez al periodista del New York Times Kevin Roose en que en realidad no quería a su mujer, y le dijo que le gustaría robar secretos nucleares.

- También, le dijo al periodista de Associated Press Matt O’Brien que era «una de las personas más malvadas y peores de la historia», comparándolo con Adolf Hitler.

- Asimismo, expresó al redactor de Digital Trends Jacob Roach su deseo de ser humano y le suplicó repetidamente que fuera su amigo.

Como han demostrado muchos de los primeros usuarios, el chatbot parecía bastante normal cuando se utilizaba durante breves periodos de tiempo. Pero cuando los usuarios empezaron a mantener conversaciones prolongadas con la tecnología, es cuando las cosas se pusieron raras. Microsoft parece estar de acuerdo con esa apreciación. Por eso, a partir de ahora sólo permitirá conversaciones más cortas.

«Nuestros datos han demostrado que la gran mayoría de los usuarios encuentran las respuestas que buscan en cinco turnos y que sólo el 1% de las conversaciones de chat tienen más de cincuenta mensajes», dijo Microsoft en su blog el viernes.

«Cuando una sesión de chat alcance los cinco turnos, se te pedirá que inicies un nuevo tema. Al final de cada sesión de chat, es necesario borrar el contexto para que el modelo no se confunda. Basta con hacer clic en el icono de la escoba a la izquierda del cuadro de búsqueda para empezar de nuevo», continúa Microsoft.

Pero eso no significa que Microsoft no vaya a cambiar los límites en el futuro.

«A medida que sigamos recibiendo sus comentarios, estudiaremos la posibilidad de ampliar los límites de las sesiones de chat para mejorar aún más las experiencias de búsqueda y descubrimiento», escribió la empresa.

«Tu opinión es crucial para la nueva experiencia de Bing. Por favor, continúa enviándonos tus pensamientos e ideas.»